- HTML Grundlagen

- SEO Onpage

- Webmastertool

HTML Grundlagen

Seitenquelltext angeschaut:<title> 65 Zeichen

<description> Beschreibungstext: Zwei Zeilen werden in der Suchmaschine werden angezeigt

<head>

Bold und Listenpunkte gesetzte Bereich werden bei Google gesondert behandelt, alles was Struktur gibt

Bloggname = h1 (Überschrift) gibt es pro Seite nur 1 x

h2 = wichtigste Überschrift, weil die meisten Artikel in dieser Überschrift sind

Ranking bei Google:

- Anhand von Parametern wird es festgelegt

- Onpage Optimierung und Offpage Optimierung (ca. 200 Paramter/Signale)

- youtube Google webmaster

Spidersimulatoren:

http://www.webconfs.com

Misst die Häufigkeit der Keywords, interne Links, interne Linkstruktur (sitemap)

Webseiten-Check (SEO-Tool)

http://www.seitwert.de

http://www.woorank.de

Quickcheck z. B. Gewichtung bei Google

Archiv von Webseiten: waybackmachine

http://www.archive.org/web/

HTML-Überprüfung

Ob das HTML sauber geschrieben ist

http://www.validator.w3.org

Webseiten-Ladezeit ananlysieren (Desktop + Mobil)

https://developers.google.com/speed/pagespeed/

Crawler Indexierung

robots txt anlegen, um Seiten / Dinge anzuzeigen oder nicht

"Crawler (auch: Bot, Robot oder Spider) ist ein Computerprogramm, das automatisiert die Dokumente im Web durchsucht. Primär wird ein Crawler für sich wiederholende Aktionen programmiert, damit das Durchsuchen gänzlich automatisiert abläuft. Suchmaschinen setzen Crawler verstärkt ein, um das WWW zu durchsuchen und einen Index aufzubauen. Andere Crawler können unterschiedliche Arten von Informationen durchsuchen... ."

SEO Onpage Faktoren

Alle jene, die auf der eigene Website beeinflußt werden können (Texte, Bilder, HTML-Quellcode, ...)SEO- ca. 200 Paramter

http://webtalk-blog.de/google-200-rankingfaktoren

Onpage Optimierung:

- HTML Validierung / CSS (auslagern) - kurz und sauber

- URL

- ist für die Ewigkeit

- ist ansprechend

- kurz und bündig mit keywords

- Keywords in den Links (interne Verlinkung)

- Bilder optimieren (URL, Titel, Alternative Text (alt),Größe...)

- Ladezeit PageSpeed (Mobil und Desktop)

- http://developers.google.com/speed/pagespeed/insights/?url=www.spiegel.de&tab=mobile

- Alter einer Domain (Waybackmachine)

- Indexierungen (je mehr im Index, desto wichtiger) / aus dem Index ausschließen geht über "noindex"

- Sitemap (Seitenstruktur dem Crawler mitgeben) im XML-Format

- Benutzerdefinierte 404 Fehler Seite anlegen

- Tote Links beheben (Weiterleitungen einrichten...)

- Robots txt (Crawler bestimmte Verzeichnisse zum Crawlen erlauben oder nicht erlauben) - http://www.suchmaschinentricks.de/aktuelles/seo/1468.php

- Metaangaben (Snippet:Title, Description...Author, News...)

http://selfhtml.org/html/kopfdaten/meta.htm#beschreibung - Strukturierte Daten Mikroformate (Personen, Rezepte, Event...) http://schema.org/Person

oder den Generator http://rich-snippet-generator.de/schema-personen.php - Typen von Rich-Snippets

- Überschriften h1-h6 (h1 einmal vorkommen,h2 momentan die Wichtigste)

- Listenpunkte, Text <strong> fett hervorheben, Textfarbe nicht gleich dem Hintergrund (Blackhat Optimierung)

- Crawler Tiefe bis 5-6 Ebenen tief - Keyword so weit wie möglich vorne stehen

- Bevorzugte Domain "canonicial Tag" anlegen (mit oder ohne www und/oder eine Weiterleitung einrichten)

- Keyword Dichte und Keyword Prominenz

- Seitwert

- Woorank

- Ranking-check

Webmastertool

Auf Seiten strukturierte Daten anlegen, eine Onpage Optimierung durchführen:Titel, Autor, Bilder etc. angeben

Bei blogger und google kann man das Webmaster Tool nutzen, um die Seite zu steuern und zu optimieren:

- Verknüpfung mit Google Analytics (mehrere Seiten)

- Übersicht der Suchanfragen und der gesuchten Terms (Suchbegriffe)

- Indexierungstatus der eigenen Seite bei google: wieviele Seiten meiner eigenen Webseite sind im Suchindex erfasst.

- Möglichkeit bestimmte Seiten aus dem Suchindex zu entfernen oder zu blockieren

- html Fehlersuche und Verbesserung

- Entfernung doppelter URL (z. B. bei der Nutzung von Permalinks)

- Crawler Aktivität beobachten und Crawler auf eigene Seite aufmerksam machen

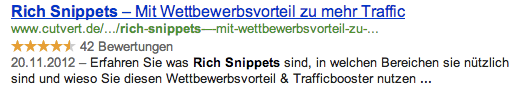

Rich Snippets sind die kleinen Ausschnitte die Ihr in den SERPS's bei Google und Co. unter der eigentlichen URL sehen könnt. Siehe Bild 1.

Diese Rich Snippets nennen sich Mikrodaten (eng. Microdata) und sind unter Schema.org zusammengefasst. Diese Daten sind auch als strukturierte Daten bekannt. Mit diesen Daten seid Ihr in der Lage, den Suchmaschinen den genauen Inhalt Eurer Seiten zu zeigen. Diese Daten sind nur für die Suchmaschinen sichtbar und beeinflussen die Besucher auf Euren Seiten in keinster Weise. Aber Ihr könnt dafür sorgen, dass eure Daten so optimal bei Google indexiert werden und die Rich Snippets perfekt angezeigt werden.

Keine Kommentare:

Kommentar veröffentlichen